随着汽车智能化趋势加速,我国智能驾驶赛道迎来爆发。当前高阶智驾产品正经历从高速场景到城市场景落地的比拼,而城市辅助驾驶被认为是迈向真正自动驾驶的最后一个挑战。毫末认为,决定这场智能驾驶产品跃迁的关键,是自动驾驶AI算法在开发模式和技术框架的颠覆性变革,而AI大模型则成为引领这场技术变革的核心变量。

2023年10月11日第九届毫末AI DAY上,顾维灏发表了主题为《自动驾驶3.0时代:大模型将重塑汽车智能化的技术路线》的演讲,分享了毫末对于自动驾驶3.0时代AI开发模式和技术架构变革的思考,同时也公布了毫末DriveGPT大模型的最新进展和实践。其中,截至目前,毫末型DriveGPT雪湖·海若已累计计筛选出超过100亿帧互联网图片数据集和480万段包含人驾行为的自动驾驶4D Clips数据;在通用感知上,进一步升级引入多模态大模型,获得识别万物的能力;与NeRF技术进一步整合,渲染重建4D空间;在通用认知上,借助LLM(大语言模型),让自动驾驶认知决策具备世界知识,能够做出更好的驾驶策略。

(顾维灏:DriveGPT通用感知与通用认知能力全面升级)

毫末智行CEO顾维灏提出:“在大数据、大模型、大算力的自动驾驶3.0时代,自动驾驶技术框架也会发生颠覆性的变化。在感知阶段,通过海量的数据训练感知基础模型,学习并认识客观世界的各种物体;在认知阶段,则通过海量司机的驾驶行为数据,学习驾驶常识,通过数据驱动的方式不断迭代并提升整个系统的能力水平。毫末一直以数据驱动的方式来推动自动驾驶产品的升级,为进入自动驾驶3.0时代做准备。”

通用感知可识别万物、通用认知学会世界知识:毫末DriveGPT引领自动驾驶大模型新范式

顾维灏认为,与2.0时代相比,自动驾驶3.0时代的开发模式将发生颠覆性的变革。在自动驾驶2.0时代,以小数据、小模型为特征,以Case任务驱动为开发模式。而自动驾驶3.0时代,以大数据、大模型为特征,以数据驱动为开发模式。

相比2.0时代主要采用传统模块化框架,3.0时代的技术框架也发生了颠覆性变化。

首先,自动驾驶会在云端实现感知大模型和认知大模型的能力突破,并将车端各类小模型逐步统一为感知模型和认知模型,同时将控制模块也AI模型化。随后,车端智驾系统的演进路线也是一方面会逐步全链路模型化,另一方面是逐步大模型化,即小模型逐渐统一到大模型内。然后,云端大模型也可以通过剪枝、蒸馏等方式逐步提升车端的感知能力,甚至在通讯环境比较好的地方,大模型甚至可以通过车云协同的方式实现远程控车。最后,在未来车端、云端都是端到端的自动驾驶大模型。

(毫末DriveGPT升级:大模型让自动驾驶拥有世界知识)

毫末DriveGPT大模型正是按照3.0时代的技术框架要求进行升级。在通用感知能力提升上,DriveGPT通过引入多模态大模型,实现文、图、视频多模态信息的整合,获得识别万物的能力;同时,通过与NeRF技术整合,DriveGPT实现更强的4D空间重建能力,获得对三维空间和时序的全面建模能力;在通用认知能力提升上,DriveGPT借助大语言模型,将世界知识引入到驾驶策略,从而做出更好的驾驶决策优化。

具体来讲,在感知阶段,DriveGPT首先通过构建视觉感知大模型来实现对真实物理世界的学习,将真实世界建模到三维空间,再加上时序形成4D向量空间;然后,在构建对真实物理世界的4D感知基础上,毫末进一步引入开源的图文多模态大模型,构建更为通用的语义感知大模型,实现文、图、视频多模态信息的整合,从而完成4D向量空间到语义空间的对齐,实现跟人类一样的“识别万物”的能力。

(毫末DriveGPT通用感知大模型:让自动驾驶认识万物)

毫末通用感知能力的进化升级包含两个方面。首先是视觉大模型的CV Backbone的持续进化,当前基于大规模数据的自监督学习训练范式,采用Transformer大模型架构,实现视频生成的方式来进行训练,构建包含三维的几何结构、图片纹理、时序信息等信息的4D表征空间,实现对全面的物理世界的感知和预测。其次是构建起更基础的通用语义感知大模型,在视觉大模型基础上,引入图文多模态模型来提升感知效果,图文多模态模型可以对齐自然语言信息和图片的视觉信息,在自动驾驶场景中就可以对齐视觉和语言的特征空间,从而具备识别万物的能力,也由此可以更好完成目标检测、目标跟踪、深度预测等各类任务。

在认知阶段,基于通用语义感知大模型提供的“万物识别”能力,DriveGPT通过构建驾驶语言(Drive Language)来描述驾驶环境和驾驶意图,再结合导航引导信息以及自车历史动作,并借助外部大语言模型LLM的海量知识来辅助给出驾驶决策。

(毫末DriveGPT认知大模型:让自动驾驶具备常识)

由于大语言模型已经学习到并压缩了人类社会的全部知识,因而也就包含了驾驶相关的知识。经过毫末对大语言模型的专门训练和微调,从而让大语言模型更好地适配自动驾驶任务,使得大语言模型能真正看懂驾驶环境、解释驾驶行为,做出驾驶决策。

认知大模型通过与大语言模型结合,使得自动驾驶认知决策获得了人类社会的常识和推理能力,也就是获得了世界知识,从而提升自动驾驶策略的可解释性和泛化性。

顾维灏表示:“未来的自动驾驶系统一定是跟人类驾驶员一样,不但具备对三维空间的精确感知测量能力,而且能够像人类一样理解万物之间的联系、事件发生的逻辑和背后的常识,并且能基于这些人类社会的经验来做出更好的驾驶策略,真正实现完全无人驾驶。”

能生成、会解释、可预测:毫末DriveGPT大模型升级带来七大应用实践

在毫末DriveGPT大模型的最新开发模式和技术框架基础上,顾维灏同时分享了自动驾驶大模型的七大应用实践,包括驾驶场景理解、驾驶场景标注、驾驶场景生成、驾驶场景迁移、驾驶行为解释、驾驶环境预测和车端模型开发。

(毫末DriveGPT应用的七大实践)

顾维灏表示:“毫末DriveGPT大模型的应用,在自动驾驶系统开发过程中带来了巨大技术提升,使得毫末的自动驾驶系统开发彻底进入了全新模式,新开发模式和技术架构将大大加速汽车智能化的进化进程。”

第一、驾驶场景理解,可实现秒级数据筛选,为图文多模态模型发掘海量优质数据。

(驾驶场景理解:开集语义图像检索)

原有自动驾驶技术方案在解决Corner case时,都需要先收集一批与此case相关的数据,然后以标签加人工的方式进行数据标注,即先对图片打上标签,然后用标签做粗筛选、再人工细筛选,成本非常高、效率非常低。现在,毫末采用通用感知大模型,可以利用图文多模态模型对海量采集图片进行目标级别和全图级别的特征提取,变成图片表征向量,并对这些海量的向量数据建立向量数据库,可以从百亿级别的向量数据库中找到任意文本对应的驾驶场景数据,实现秒级搜索。

基于这一能力,毫末还构建了专有的自动驾驶场景多模态数据集,训练了毫末的图文多模态模型,来对如鱼骨线、双黄实线车道线等理解难度较大的驾驶环境特有场景进行专门训练和学习。

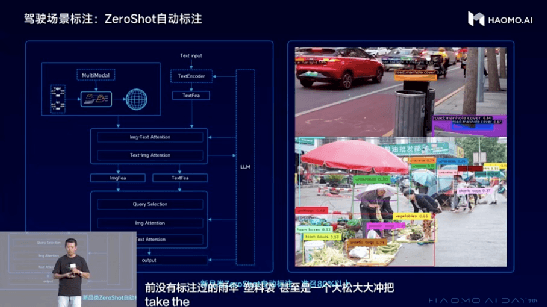

第二、驾驶场景标注,实现更高效的Zero-Shot的自动数据标注,让万物皆可被认出。

(驾驶场景标注:zeroShot自动标注)

原有的自动驾驶感知算法,仅仅能识别人工标注过的有限个品类的物体,一般也就几十类,这些品类之外的物体都无法识别,通常称之为闭集(Closed-set)数据。毫末通过图文多模态大模型将原有仅识别少数交通元素的闭集场景标注,升级为开集(Open-set)场景中进行Zero-Shot的自动标注,从而应对千变万化的真实世界的各类驾驶场景,实现对任意物体既快速又精准的标注。

通过多模态技术对齐图文表征,再利用大语言模型辅助用于提供开放词句的表征能力,最终完成Zero-Shot的自动标注。通过该方案,毫末不仅实现了针对新品类的Zero-Shot快速标注,而且精度还非常高,预标注准召达到80%以上。

第三、驾驶场景生成,实现无中生有的可控生成技术,让Hardcase不再难找。

(驾驶场景生成:无中生有的可控生成)

为应对海量数据中相关困难场景(Hardcase)数据不足的问题,毫末基于DriveGPT大模型构建了AIGC能力,从而生成平时难以获取的Hardcase数据。基于毫末丰富的驾驶数据,训练了驾驶场景的AIGC模型,可通过输入标注结果,比如路口、大区率弯道等车道线,再以这个标注结果为Prompt来生成对应的图像。基于这样的可控生成的图像,一方面可以通过标注进行更加精细的位置控制,另一方面也让新生成的数据自带了标注信息,可以直接用于下游任务的训练。

第四、驾驶场景迁移,通过瞬息万变的场景迁移技术,实现全天候驾驶数据的同时获取。

(驾驶场景迁移:轻松获取全天候驾驶数据)

除了基于标注结果的数据生成之外,DriveGPT还可以进行高效的场景迁移。通过引入文字引导,AIGC生成能力可以用单个模型实现多目标场景生成。基于毫末的感知大模型,以真实的采集图像作为引导,通过文本语言来描述希望生成的目标场景,可实现清晨、正午、黄昏、夜晚等多时间段光照变换,同时也可把晴天转换为雨天、雪天、雾天等各种极端天气。通过这种方式,能将采集到的一个场景,迁移到该场景的不同时间、不同天气、不同光照等各类新场景下,极大地丰富了训练数据,提高模型在极端场景下的泛化性。

第五、驾驶行为解释,通过引入大语言模型,让AI解说驾驶场景和驾驶策略。

毫末DriveGPT原本对自动驾驶策略解释的做法是引入场景库、并对典型场景用人工标注的方式给出驾驶解释,这次升级则是通过引入大语言模型来对驾驶环境、驾驶决策做出更丰富的解释,相当于让AI自己解释自己的驾驶策略。

首先,将感知大模型的结果解码得到当前的感知结果,再结合自车信息和驾驶意图,构造典型的Drive Prompt(驾驶提示语),将这些Prompt输入大语言模型,从而让大语言模型对当前的自动驾驶环境做出解释。其次,大语言模型也可以对自动驾驶系统所做出的驾驶行为给出合理的解释,掌握例如为什么要加速、为什么要减速、为什么要变道等,让大语言模型能够像驾校教练或者陪练一样,对驾驶行为做出详细的解释。大语言模型的引入,一方面能解决大模型不可解释的问题,另一方面也能基于这些驾驶解释来进行驾驶决策的优化。

(驾驶行为解释:让AI解释自己的驾驶决策)

第六、驾驶环境预测,让DriveGPT具备社会常识,从而可以准确地预测未来场景。

DriveGPT原有采用生成式预训练的方式,使用海量司机驾驶行为进行预训练以及引入大量司机接管数据座位人类反馈数据进行强化学习,从而基于已有的BEV场景来更好预测生成未来几秒的BEV场景。但是DriveGPT需要具备像人类一样对社会常识、社会潜规则的理解,并基于这种潜规则做出更好的预测。因此,除了使用驾驶行为数据,DriveGPT还需要引入大语言模型,才可以在预测规划中融入人类社会的知识或常识,才能给出更合理的驾驶决策。

顾维灏认为:“我们相信,必须要引入大语言模型,才能让自动驾驶具备常识,而自动驾驶必须具备常识,才能理解人类社会的各种明规则、潜规则,才能跟老司机一样,与各类障碍物进行更好地交互。”

(驾驶环境预测:更像人类一样预测未来场景)

第七、车端模型开发,把大模型蒸馏成小模型,从而在有限车端算力上得到更好效果。

大模型训练需要依靠云端的海量数据和超大算力,短期内难以直接部署到车端芯片,而如何让大模型的能力帮助车端提升效果,可以采用蒸馏的方式。第一种蒸馏方法是使用大模型来输出各类伪标签,伪标签既可以作为训练语料,来丰富车端小模型的训练数据,也可以作为监督信号,让车端小模型来学习云端大模型的预测结果;第二种蒸馏方法是通过对齐Feature Map的方式,让车端小模型直接学习并对齐云端的Feature Map,从而提升车端小模型的能力。基于蒸馏的方式,可以让车端的感知效果提升5个百分点。

(车端模型开发新模式:把大模型蒸馏成小模型)

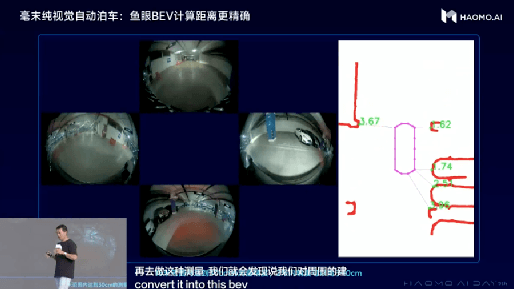

纯视觉泊车、道路全要素识别、小目标检测:毫末DriveGPT赋能车端感知提升

毫末利用视觉感知模型,使用鱼眼相机可以识别墙、柱子、车辆等各类型的边界轮廓,形成360度的全视野动态感知,可以做到在15米范围内达到30cm的测量精度,2米内精度可以高于10cm。这样的精度可实现用视觉取代USS超声波雷达,从而进一步降低整体智驾方案成本。

(毫末纯视觉泊车)

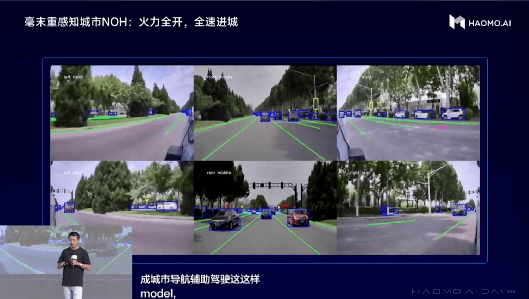

基于DriveGPT基于通用感知的万物识别的能力,毫末对交通场景全要素识别也有了较大提升,从原有感知模型只能识别少数几类障碍物和车道线,到现在可以识别各类交通标志、地面箭头、甚至井盖等交通场景的全要素数据。大量高质量的道路场景全要素标注数据,可以有效帮助毫末重感知的车端感知模型实现效果的提升,助力城市NOH的加速进城。

(毫末城市NOH感知全要素识别)

基于DriveGPT的通用语义感知模型能力对通用障碍物的开集场景标注,可实现对道路上小目标障碍物检测也有较好的效果。毫末在当前城市NOH的测试中,可以在城市道路场景中,在时速最高70公里的50米距离外,就能检测到大概高度为35cm的小目标障碍物,可以做到100%的成功绕障或刹停,这样可以对道路上穿行的小动物等移动障碍物起到很好地检测保护作用。

(毫末城市NOH小目标障碍物检测)

历届HAOMO AI DAY的核心主题都是聚焦最硬核的自动驾驶AI技术,这次更是专门聚焦AI大模型对于自动驾驶技术的赋能,提出了探索端到端自动驾驶技术路线的一种新可能。

正如顾维灏在结尾说道:“毫末即将成立四周年,一约既定,万山无阻。毫末人将继续用AI连接更广阔的世界,用技术叩问更浩远的未来。”HAOMO AI DAY成为中国自动驾驶技术的一面旗帜,同时也正在成为毫末向年轻的AI人才发出邀请的最好的一扇窗口。

来源:第一电动网

作者:王鸣幽

本文地址:https://www.d1ev.com/news/qiye/211414

文中图片源自互联网,如有侵权请联系admin#d1ev.com(#替换成@)删除。