为期五天的全球顶级的年度计算机视觉会议,CVPR(计算机视觉与模式识别)已经在加利福尼亚州的长滩市落下帷幕。

计算机视觉在自动驾驶拥有着一席之地,甚至有从业者认为纯视觉可以实现自动驾驶,所以在CVPR2019舞台,自动驾驶也成为了其中重要的内容。包括国外的Waymo、Argo、NVIDIA、Tesla、Algolux等,国内的美团、百度、驭势等公司都纷纷在CVPR 2019上亮相或发布重要产品。

即便是不参会的国内自动驾驶公司,也有相当一部分会员工,不管是因公出差还是个人兴趣,都远涉重洋来到加州长滩,参加一年一度的计算机视觉顶级会议。

在公司层面,Waymo和Argo先后在CVPR 2019上宣布开放数据集,百度则宣布推出纯视觉的L4级别自动驾驶解决方案、美团无人配送团队获得CVPR 2019障碍物轨迹预测挑战赛第一名,NVIDIA和Algolux则在摄像头方面有新动作。

至于全球各地5160篇论文,被收录1294篇的梗,这里就不一一介绍了。下面看看自动驾驶领域,更有意思的内容。

01 Waymo与Argo开放数据集

在CVPR 2019上,全球自动驾驶领头羊Waymo发布了自动驾驶数据集Waymo Open Dataset,随后福特旗下的独立自动驾驶公司Argo也宣布开放自动驾驶数据集Argoverse。

在2019年3月Aptiv开放的自动驾驶数据集Aptiv NuScenes数据集前,研究人员发布的数据集相对小,并且范围有限,通常也仅限于摄像头图像数据。随着Waymo和Argo的数据集开放,自动驾驶领域迎来更为丰富的数据集。

Aptiv NuScenes数据集包括了图像激光雷达和毫米波雷达数据,而Waymo开放的数据集Waymo Open Dataset则声称拥有3000个场景,是NuScenes的三倍,并且相机和激光雷达信息之间更好的传递,更重要的是,Waymo提供了五个激光雷达传感器的数据,而Aptiv NuScenes只有一个。

福特旗下的Argo的数据集Argoverse则有不同之处,在规模上,这个数据集只涵盖了迈阿密和匹兹堡录制的113个场景,包括了9个摄像头的数据以及2个激光雷达传感器的数据。

但是,Argoverse数据集是唯一一个包括高清地图数据的数据集。目前,Argo在自己运营的区域内建立了自己的高清地图,覆盖了匹兹堡和迈阿密290公路的道路,涵盖了位置、海拔、交通信号等信息。Argo对其映射解决方案的一个特点是能够通过准确了解寻找符号和信号的位置来优化处理,而不必扫描整个场景寻找信号。

02 百度的方案和美团的头名

作为计算机视觉的顶级会议,怎么少得了自动驾驶的纯视觉解决方案呢!作为纯视觉解决方案的拥趸Tesla,并且计划在2020年推100万辆RoboTaxi的Tesla,并没有在CVPR2019上展示自己的方案,毕竟距离4月份的Tesla AutonomousDay刚过去没多久,所以Tesla展示了Roadster 2。

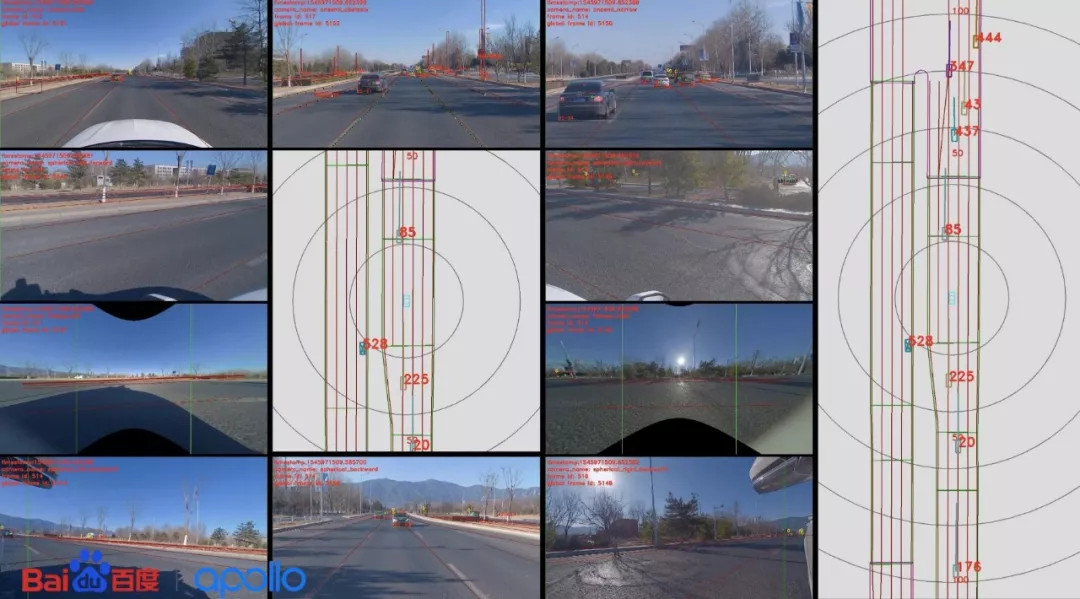

但是,来自中国的百度Apollo,则推出了纯视觉的L4级自动驾驶城市道路闭环解决方案——百度Apollo Lite。这个发布验证了此前业内流传的百度重回L4纯视觉方案的消息。

按照百度官方的说法,Apollo Lite能够支持对10路摄像头(Tesla Autopilot应该是8个摄像头)、200桢/秒的数据进行处理,其他数据包括单视觉链路丢帧率控制在千分之五以内,前向障碍物检测视距为240米。

在6月21日,百度在长沙拿到了45张自动驾驶测试牌照,按照官方计划,百度计划在下半年推出100辆RoboTaxi。但Apollo Lite目前是在北京稻香湖等路段测试。未来,百度的L4级别自动驾驶,会采取此前的激光雷达技术路线还是纯视觉的技术路线呢?

另外一个中国互联网巨头美团(美团市值超过了百度),旗下的无人配送团队(这是送外卖起家的美团的刚需),则斩获了CVPR 2019障碍物轨迹预测挑战赛第一名。

这个比赛主要是让来自学术界和工业界的研究人员和工程师,讨论自动驾驶中计算机视觉的应用。具体就是在比赛中,各参赛者根据每个障碍物过去3秒的运动轨迹,来预测未来3秒的运动轨迹。

障碍物的类型包括了四种类型:行人、自行车、大型机动车、小型机动车,最终美团以1.3425的成绩获得这个比赛的第一名。美团之所以能拿头名,是因为美团无人配送在研究障碍物对无人配送车的影响。

03 最新的摄像头方案

首先介绍NVIDIA的方案在城市交通的应用,作为GPU起家的NVIDIA在视觉方面的能力毋庸置疑,在CVPR 2019上,NVIDIA则介绍了CityFlow的一个多目标多摄像头车辆跟踪和再识别的城市尺度基准。

利用交通摄像头作为传感器进行城市交通优化,推动了多目标多摄像头(MTMC)跟踪技术的发展。这项工作介绍了CityFlow,这是一个城市规模的交通摄像头数据集,包含超过3小时的同步高清视频,来自10个十字路口的40个摄像头,两个同步摄像头之间的最长距离为2.5公里。

CityFlow是城市环境中空间覆盖率和摄像机/视频数量最大的数据集。数据集包含超过200K的带注释的边界框,涵盖了广泛的场景、视角、车辆模型和城市交通流条件。提供相机几何和校准信息,以协助时空分析。

此外,基准测试的一个子集可用于基于图像的车辆重新识别(ReID)任务。NVIDIA对MTMC跟踪、多目标单摄像机(MTSC)跟踪、目标检测和基于图像的ReID等基线/最新方法进行了广泛的实验评估,分析了不同的网络架构、损失函数、时空模型及其组合对任务效率的影响。

在2019年人工智能城市挑战赛上,NVIDIA发布了基准测试,并推出了一个评估服务器,允许研究人员比较他们最新技术的性能。NVIDIA希望这个数据集能够催化这一领域的研究,推动最先进的技术向前发展,并导致部署在现实世界中的交通优化。

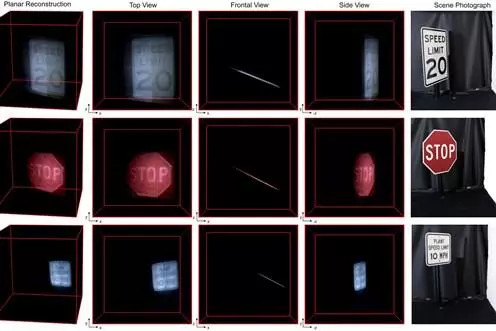

Algolux的方案就厉害多了,这家公司宣布和蒙特利尔大学、普林斯顿大学共同研发了一种新方法,采用传统的CMOS摄像头,如智能手机或汽车上的CMOS摄像头,可以“透视”被墙壁或其他场景遮挡的物体。

Algolux声称,开发人员已经为非视距(NLOS)成像实现了前所未有的分辨率。该技术使相机传感器第一次能够以高分辨率和角落周围的颜色看到物体。利用这项技术,开发人员能够重建交通标志和其他被一些较大物体或墙壁隐藏的其他3D物体的高质量图像。

自动驾驶技术严重依赖于雷达和一系列摄像机,该技术有望成为改进自动驾驶技术的重大发展。它将确保在道路情况困难且视野受阻的地区为自动驾驶车辆提供更安全的导航。

与此同时,来自卡内基梅隆大学,多伦多大学和伦敦大学学院的研究人员展示了一种非视距(NLOS)成像技术,能够计算出弯曲物体的毫米级和微米级形状。非视距成像旨在通过分析它们在可见场景表面上的间接反射来恢复被遮挡的物体。

卡内基梅隆大学的研究得到了美国国防高级研究计划署的Reveal计划的支持,该计划正在开发NLOS功能。更为重要的是,该研究获得CVPR 2019最佳论文奖!

人是依靠视觉来安全驾驶,但背后是高度精密的大脑和经验判断,这是目前计算机处理芯片所不具备的能力。

计算机视觉是自动驾驶领域不可获取的一环,但是,纯视觉的方案能完全实现自动驾驶吗?类似Algolux和卡内基梅隆大学的研究,或许能够给我们答案。

来源:车智

本文地址:https://www.d1ev.com/news/jishu/93434

文中图片源自互联网,如有侵权请联系admin#d1ev.com(#替换成@)删除。