蔚来最近迎来了 NIO OS 2.3 的更新,最直观的感受是选装了 NIO Pilot 完整功能(以下简称 NP )的尊蔚主(尊贵的蔚来车主,买了 NP 的那种)们能直观的通过动态仪表盘看到 NP 眼中的世界,而动态画面中出现的和实际观察不一致的情况,也引发了很多车主关于 NP 到底行不行的讨论。

以下文字来自蔚来碳粉创始成员、魏雪芬家族元老、导弹专业毕业、资深通信狗「亚森罗宾」。

他从硬件与软件两个维度,就 OS 2.3 之后的 NIO Pilot 表现做了深度的分析,并对目前车主的一些疑问进行了解答。

特别提醒,蔚吹饮品,服用需谨慎!

以下,Enjoy!

先上结论:

1、NP 的动态仪表显示的内容超出了我之前预期,也超出绝大部分厂商,仅次于特斯拉 AutoPilot(以下简称 AP )。

2、NP 是目前国内乘用车市面上能买到的仅次于 AP 的辅助驾驶,从功能上来说 AP 略> NP 略>ALL,而从潜力上来说 AP > NP >> ALL。

此图版权属于@雨

再提出几个疑问:

1、为什么明明后面过来个电瓶车,显示的却是汽车,到前面又变回电瓶车?

2、为什么有时候侧面会发生虚拟的「车祸」

3、为什么装了箱子的美团电瓶车会被识别为卡车?

4、为什么显示的车会来回晃动,为什么并排的车可能会不显示?

5、碰到加塞的,交通流显示出来加塞,车为什么没采取措施?

6、NP 和 AP 到底有多少差距,我们到底需要多久才能赶上特斯拉?

接下来我们从硬件、软件两个维度分析。

1、基本逻辑

目前辅助驾驶的基本逻辑,就是模拟人的驾驶逻辑,可以简单分为感知、决策、执行三个过程。

车载的传感器负责感知(其实只负责接收信号):摄像头——相当于人的眼睛;雷达——相当于人的耳朵;芯片负责感知和决策(将信号转化、决策、和发出执行信号)——相当于人的大脑;电动车的电气化架构又使得“执行”有着先天优势,也是为什么电动车往往比油车辅助驾驶做的好的原因之一。

大家都知道,人类的眼睛是可以接收到具体的图像来感知和构建这个世界,耳朵却只能通过“听音辨位”。而辅助驾驶最难的难点之一,就是通过传感器感知周围环境。

和生物的眼睛、耳朵不同的是,虽然很多摄像头从参数上已经能超过人眼,但是人眼背靠大脑这个强大的后盾(俗称脑补)从图像处理能力上来说完胜世界上最精密的计算机,而人类还有肌肉这个神奇的东西能极大的增加两只眼睛的可视范围,所以机器需要用不同功能的摄像头来弥补。

作为耳朵的雷达,比人类的耳朵多出距离感知甚至成像的能力。

2、摄像头

摄像头有个特性:看的远的看不广,看的广的看不远。

这就是为什么手机采用多摄方案,以达到又能拍摄长焦又能拍摄广角的效果。而辅助驾驶如果用纯摄像头(视觉)方案,需要在车身上部署多个不同的摄像头,来实现不同距离、不同范围的视觉采集。

马斯克的想法就是最大程度模拟人类驾驶一系列过程,摄像头的好处就是和人眼一样能直接生成图像,从上面的图里可以看出,摄像头眼中的世界和我们人类看到的差不多。但是对于图像中内容的提取和判别十分困难,需要大量的学习和训练——这也是人工智能中最重要的一个分支。

视觉感知也有缺点,就像人眼一样,在雨、雾等恶劣天气、逆光等条件会受到比较强烈的干扰,并不一定能在“全天候”情况下使用。

3、雷达

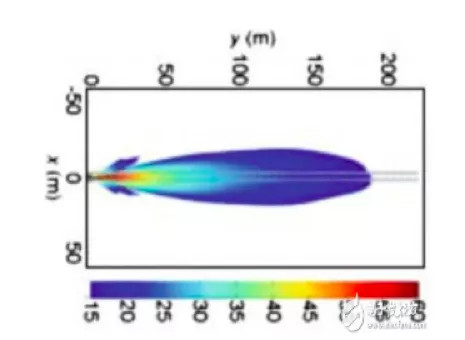

为了解决人眼(同理摄像头)可视距离短、受天气等干扰的缺点,人类发明了雷达。雷达能感知的世界就纯粹的多,也虚幻的多。雷达的原理很简单,主要测量目标的三个参数:位置、速度和方位角。雷达眼中的世界基本上就如下图。

再转换一下就如下图。

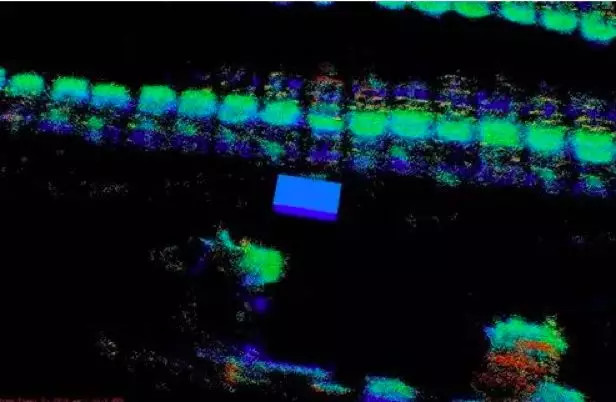

当然,随着技术的进步,在军事上通过雷达信号特征(比如反截面积)来判断不同物体,或者通过雷达成像技术来形成图像(合成孔径雷达、激光雷达),现在在研发中的车载毫米波雷达已经能看到下面这样的图像,可以很清晰的看到有一辆车开着车门这样的信息。

目前车载主流采用的长距离雷达都是毫米波雷达,大家可能比较陌生,放一张图大家就比较熟悉了,长弓阿帕奇头顶的那个圆形的东西就是毫米波雷达,虽然原理一样,但要比车载的强大无数倍。

而号称高级别辅助驾驶必须的激光雷达,其实也有他的局限性。

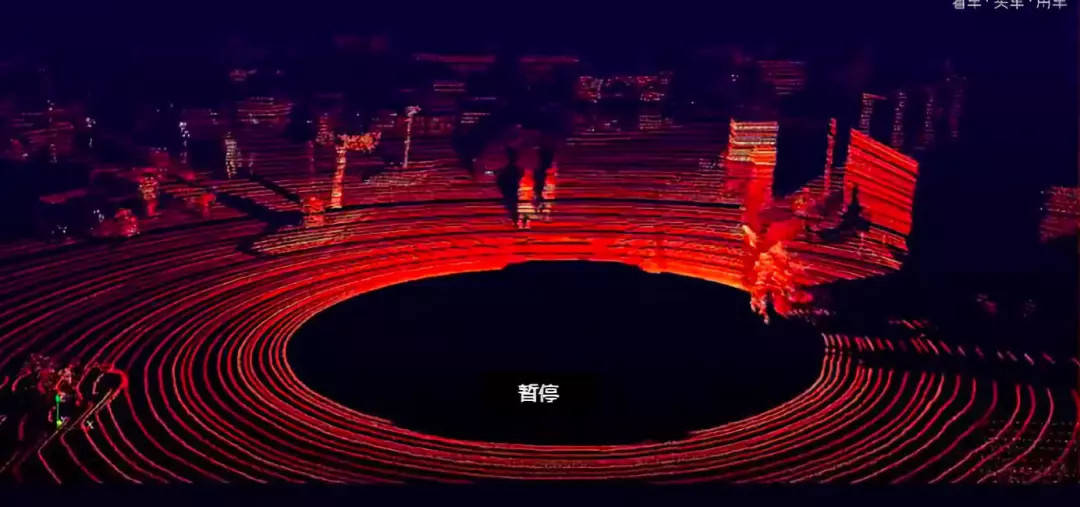

激光雷达的优点是分辨率高,从而能进行成像并构出物体的轮廓图(下图就是激光雷达眼中的世界),缺点(不说价格,说价格就是一辆车)是容易受雨雾天气影响。

而毫米波雷达不受这些影响。但是雷达波反射金属等物体比较好,对于人体、木头等探测能力较弱,而且容易受到物体干扰,比如一个易拉罐可能会误认为是车。

特斯拉拥有「7只眼睛」。

其中 3 只眼睛负责前向的视觉(类似人眼),装在翼子板和 B 柱的 4 只眼睛负责侧方和后方的视觉。而融合起来的视觉,除了正后方盲区以外,几乎可以覆盖全部周围的视觉,正面的视觉最大可以达到250 米,主摄像头可以 150 米,正面的视觉范围大约是 150 度,而侧方的摄像头能观察 80-100米 的距离,从而形成一个完整的空间感知。

蔚来的三只眼睛和特斯拉基本差不多,也能在前向 150 度和百米范围观察世界,但是剩下的范围就需要通过四个角毫米波雷达来进行感知。

目前蔚来采用的角毫米波雷达还是市面常见的 24GHZ 雷达(别问成像雷达,问就是一辆车的钱),能探测距离、速度、角度。

这就解决了我们最上面的第一个疑问:为什么明明后面过来个电瓶车,显示的却是汽车,到前面才会变成电瓶车。

因为雷达只能感知侧后方过来的物体,而不能判别到底是汽车还是电瓶车,算法统一标记为汽车,等物体到了三目可视范围内,才会识别为正确的物体。够用,但不酷炫。

而其他厂商,一般采用单目摄像头的方案,为了能看的远一点,可视的角度就会变的很小,加上没有采用前角毫米波,正面的感知范围就会变得很小,比如下图,正面的视觉可视范围就比蔚来小的多。

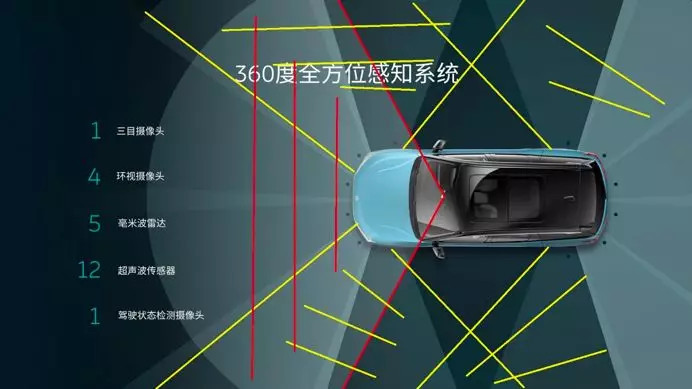

通过官网的一张图我来做一下灵魂画手,红色标记的范围是三目摄像头的可视范围,黄色标记的范围是毫米波(可能)探测的范围。

可以看到,在侧面近距离是有探测盲区的,值得夸赞的是,蔚来做了两个毫米波雷达和三目视觉的融合,并且展示在动态仪表盘上,上面我们已经说了,雷达和摄像头看到的世界是不一样的,要把他们的信号转换成图像再拼接起来很不容易,虽然现在还不完美,但已经超过了我之前的预期(我预期到底是有多低)。

同时,这就解决了上面的第四个疑问:为什么显示的车会来回晃动,为什么并排的车可能会不显示?

4、芯片

特斯拉自研的 HW3.0 芯片 AI 算力达到惊人的 144TOPS(万亿次每秒),蔚来采用的 MobileyeQ4 仅仅为 2.5 TOPS,将来的MBQ5 会是 25TOPS。而小鹏 P7 将来会搭载的 NVIDIA Xavier(没错,就是专做显卡几十年的那家,特斯拉 AP2.0 和 AP2.5 的芯片供应商)也仅仅是 21-30TOPS。

那巨大的算力差距是否代表辅助或者自动驾驶巨大的差距呢?并不完全是这样。

特斯拉采用 7 个摄像头几乎纯视觉方案需要的算力远远大于其他家,而蔚来只需要处理三个摄像头和四个雷达的数据需要的运算量大大减少。

5、总结

从硬件上可以看出,特斯拉拥有最强的大脑和多达 7 只眼睛;蔚来拥有较强的大脑和 3 只眼睛、5 只耳朵,其中三只眼睛负责前向的视觉,五只耳朵负责视觉盲区的感知;而其他家一般要么就是大脑较强,但是只有一只眼睛和一只耳朵,要么只拥有很普通的大脑。

这里要重点说说某鹏,其实它的耳朵(有 2 个后角毫米波雷达)数量并不少,但是从公开只言片语看,Mobileye 和 NVIDIA 并没有提供市面上顶级的芯片给到 G3,算力不足大大限制了发挥,而在下一代P7上NVIDIA提供了Xavier芯片会拉回不少劣势,但是Xavier是否能满足数十个摄像头、多个高精度雷达信息的处理,以及路径规划、决策、控制这么多需求的算力,从而实现现在并不知道是否存在的L3级辅助驾驶,仍然存在疑问。

软件

从表象来看,蔚来软件和特斯拉的差距并不大(UI、ADAS 功能),但是背后的差距有一条护城河那么宽,而传统厂商通过博世方案提供的ADAS,和蔚来又有巨大的鸿沟。

上面我们说了,辅助驾驶分为感知、决策、执行三个过程,蔚来在感知层面是用的 MobileyeQ4 提供的现成数据,同时针对性的进行了一定的优化。

简单的说就是你的摄像头输入图像,MBQ4 芯片会直接告诉了你这是汽车、这是电瓶车、这是卡车,蔚来并再次做了视觉识别的很多工作,这是一个极其重要的基础。

特斯拉构建了一整套视觉及神经网络,通过训练神经网络模型来识别更多的物体、做出更正确的决策,这也是特斯拉最大的核心竞争力。

一个好消息是将来的 MobileyeQ5 芯片(听说蔚来也会首装),会开放让车企自己来写感知算法,而拥有坚实基础的蔚来,会比其他厂商走的更快更远。

回到上面的疑问,为什么装了箱子的电瓶车会被识别为卡车?也许因为欧美没有我们这样“美团”电动车,而箱子的特征和厢式卡车又是差不多的,所以直接识别为了卡车。

根据之前公开的信息,蔚来自己负责决策部分的开发。但是蔚来并没有特斯拉那样“收集用户数据”和“影子模式”来不断优化决策,而是更多的通过道路测试、计算机模拟来积累里程——不够高效,但同样能达到目的。

所以碰到近距离加塞的,交通流显示出来加塞,但是车没采取措施。蔚来在决策的开发上,还有进步的空间。

惊喜和遗憾

惊喜1、上文说到,最大的惊喜还是蔚来做了不同传感器数据的融合,虽然并不完美,但是仍旧可以不断的优化,自研的优势就在这里。

惊喜2:蔚来能识别正前方垂直开过的车辆侧面,这点无论在 AP上还是小鹏XP 上我都没有发现。

遗憾1:2.3 版本的 NP 仍旧不能显示行人信息,这点其他厂商早就已经能显示,而 MobileyeQ4 是可以直接识别行人的,蔚来也许还在做二次的识别和优化。

最后的最后,蔚来到底需要多久才能赶上特斯拉?分两个部分来分析。

1、感知能力和范围:

比如某家车企在没有后向感知能力的情况下推出了 ALC(转向灯变道)功能,这是极端不负责任的,在使用 ALC 时候很大概率会发 生本车全责的追尾事故。而 AP 和 NP 的前向视觉感知能力,也要远超采用单目摄像头的其他辅助驾驶。

2、目标不同:

AP 这套硬件设计之初是朝着 L4 甚至 L5 级的自动驾驶去的(中间经历过两次更换芯片,2016 年就该实现的目标到目前还未实现),而蔚来一代平台的目标是高级别的 L2 无限接近 L3,这很快就能实现。

3、实现方式不同:

AP 采用比较激进的、一条谁也没走过也不知道能不能走得通的路——纯视觉感知,而 NP 采用了比较成熟而又比其他家更先进、更全面的方案——融合感知。

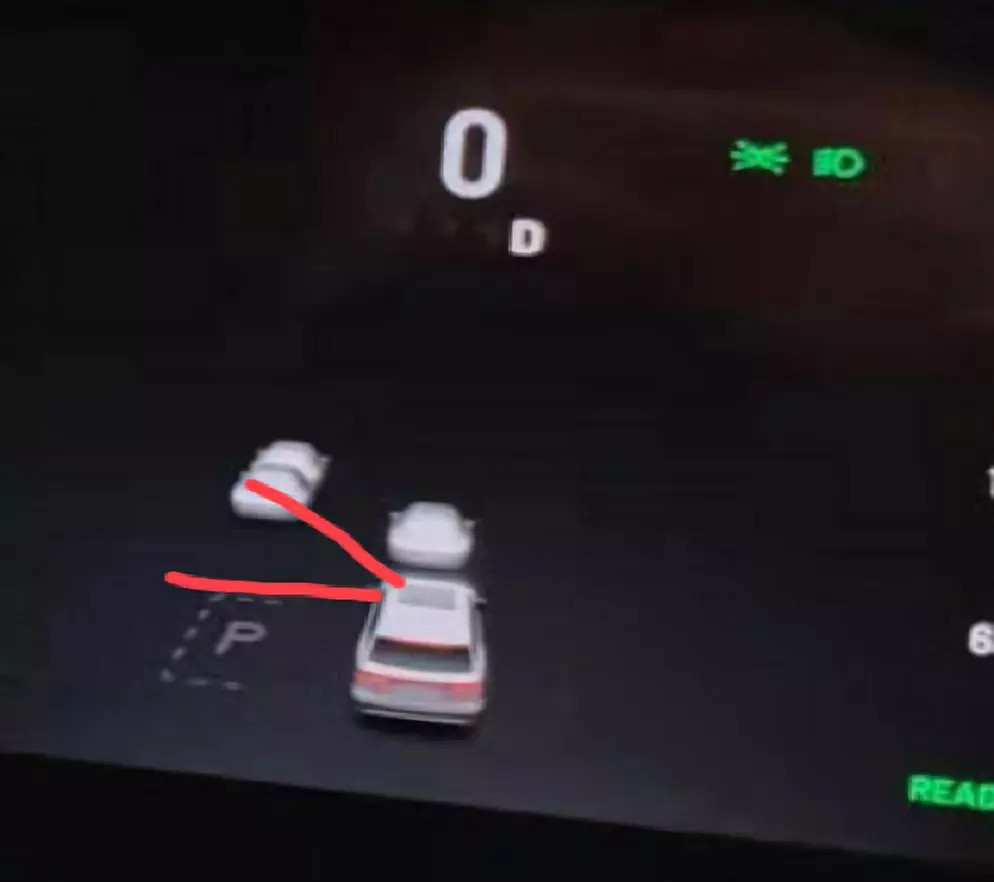

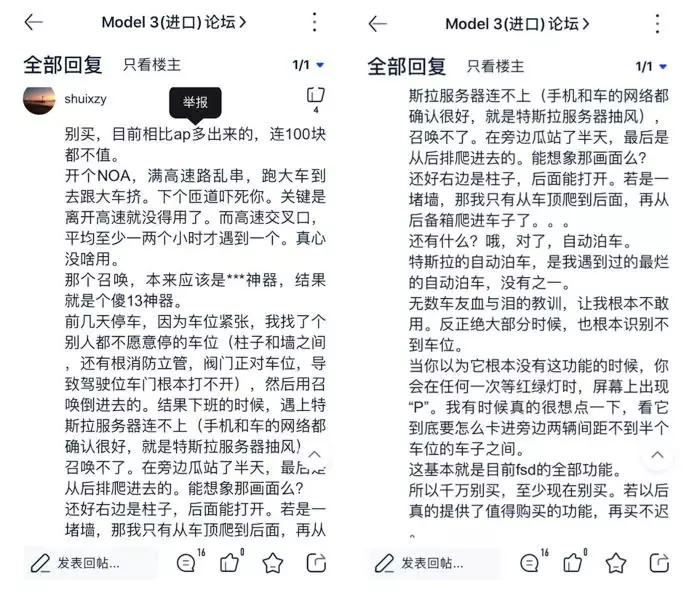

从实际使用上,目前 AP 和 NP 基本处于同一水平,AP 中 FSD(完全自动驾驶)目前在国内可用的召唤(直进直出类似比亚迪遥控),和 NOA(根据导航自动驾驶)处于比较初级的阶段——前一阵还忘了给中国区推送。

而蔚来不远的将来可能就能推出更符合中国路况的 NOA 功能。从性价比角度,3.9万 的NP完整功能值回票价(还不到车价的 10%),而 5.6万(几乎是车价的 20%)的 FSD 目前在国内还不值这个价格(见下图吐槽),如果一台智能电动车,你不选购——尤其非通用方案、有厂商特色的辅助驾驶系统——这台车的魅力就会少了一大半。

NP已经远超过AP1,达到目前AP版本80%的功力…我相信,蔚来会通过自研,牢牢掌握住辅助(自动)驾驶技术上的核心竞争力,而本土化的优势,使得 NP 将来会成为最适合中国路况的辅助(自动)驾驶系统。

(完)

来源:第一电动网

作者:电动星球News蟹老板

本文地址:https://www.d1ev.com/kol/101893

文中图片源自互联网,如有侵权请联系admin#d1ev.com(#替换成@)删除。