茨威格说过,一个真正具有世界历史意义的时刻—— 一个人类群星闪耀的时刻出现以前,必然会有漫长的岁月无谓地流逝而去。

类似的话,中国古人也说过:“天不生仲尼,万古如长夜”。你知道的,仲尼来的时候,不是一个人,而是一票人,他们一起争奇斗艳,改写了其后的2500年。

不知道历史进度条是否被突然加速了,还是这一代人原本就是这么幸运,还是别的什么——在2024-2025年的某些时刻,我们忽然有了这样的感觉:群星正在遥遥升起,即将划过头顶的夜空。

具体的说,是2024年11月和2025年9月,中国智驾行业突然出现的两次拐点,在【智驾大赛】上表现为参赛成绩突然大幅提升,被参赛车友和裁判惊讶地捕捉到,快速溢出到更大范围的车友群里。

把这两次拐点串起来看,你会看到一条清晰的脉络,这就是国内智驾行业头部阵营过去两年里攀登天梯的脉络:

1、E2E 车端模型(参数量2B-4B),从2024年Q4的 “两段式(感知 + 规控分阶段)” 迭代为2025年Q4的 “一段式(单模型全流程)”,在结构化城市场景的能力与体验上已逼近特斯拉FSD V13;

2、云端基座模型(参数量多为30B-70B),从2024年Q4的 “BEV+OCC+Transformer(感知底座)”,迭代升级为2025年Q4的“VLA(认知决策)+WA(世界建模)+RL(行为优化)+Transformer(核心骨干)”复合架构 —— 在保留原感知优势的基础上,融入多模态理解与因果推理能力,打开了跨域应用的大门。

2025年度,谁在推动智驾进步?今天起,我们将推出《2025中国智驾开发者50人》系列,分5期刊发。

入围的80多位候选人,绝大多数在国内,少数在国外,个别是海外华人。他们的研发成果,体现在过去两年里发生的两次智驾拐点上。但其中的大部分,都很低调。

入围的标准有两条(个别极其优秀者例外):

1、2025年内,在全球顶会顶刊发表高引论文的第一作者(含合著团队);

2、2025《智驾天梯榜》年度榜单上榜方案商和主机厂的核心研发人员。

经过核实与比对,最终挑选出50位有代表性的人物。他们的身份,大体分四类:

1、学术研究者,在顶会顶刊上发表高引论文的作者(含作者团队);

2、研发组织者,定投资、定方向、定目标、定范式、定团队的人,类似奥本海默;

3、研发骨干,负责某一个具体方向的研发统筹,并和兄弟们一起拼搏出成果的人;

4、产品和工程负责人,负责产品定义、用户交互、工程实施的人,做出了非常棒的产品体验,或者保障了连续的工程交付表现。

今天第一期,推荐11篇卓越论文的作者们。每篇论文都可能是团队协作完成,亦或由不同单位之间的团队协作完成。本文主要记录第一作者,兼带介绍合著团队(排名不分先后)。

#01

杨磊:在“海拔高度”中寻找纯视觉感知的精确性

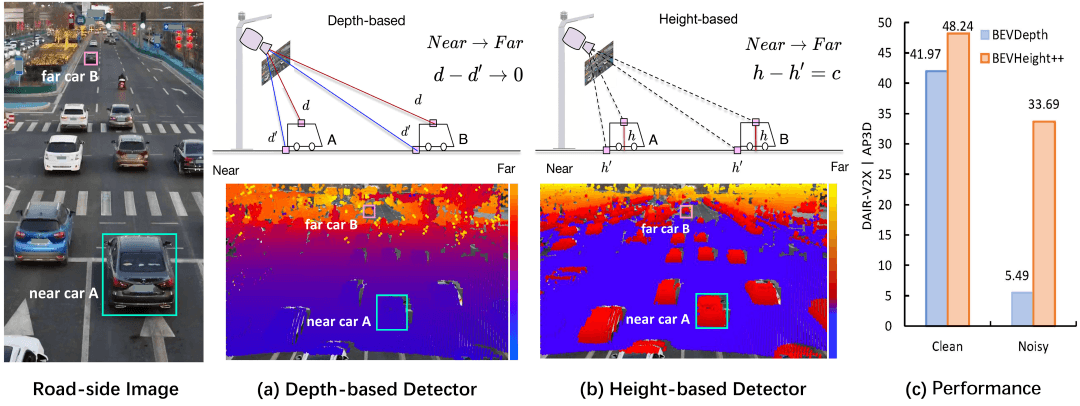

学术成果:《BEVHeight++: Toward Robust Visual Centric 3D Object Detection》(3D目标检测通用框架)

第一作者:杨磊,清华大学2020级博士研究生;合著团队:清华大学李骏院士团队

发表时间:2025年3月11日(发表于IEEE TPAMI)

(图片来源:清华大学研究生教育)

2023年前后,视觉3D检测正陷入一场“深度纠结”——行业标配的做法是先预测“深度”,再投影。但他敏锐察觉到了视觉的天然软肋:摄像头预测的深度就像盲人摸象,尤其在遇到坡道或车辆颠簸时,预测出的深度会产生剧烈抖动,导致感知结果“满屏乱飘”。

那什么是可靠的?他和团队想到了“高度”。即便地面有坡度,车与路面的相对高度是相对稳定的物理量。这就好比在原本松动的地基(深度)旁,打下了一根名为“海拔高度”的钢筋。通过对像素高度信息的挖掘,在不增加额外硬件传感器(不加LiDAR)的情况下,提升了视觉感知在三维空间中的定位精度。

这意味着,可以用成本可控的摄像头方案,达到接近昂贵传感器的感知效果,这对降低量产车成本至关重要,所以BEVHeight++的角色,是“全场景感知的稳定器”,它让自动驾驶汽车在面对复杂的上下坡、颠簸路面,以及在与智能路侧设备“对话”时,拥有一双更准确、更不容易被欺骗的“三维眼睛”,它让纯视觉3D感知不再是一个“脆而易碎”的估算模型,而变成了一个具备几何约束的稳定工程方案。

这份学术成果的意义,是让自动驾驶系统在高速场景下的判断更稳,在复杂起伏的城市立交桥上,实现了打通“车路协同”最后一步的可能。

曹家俊:在算力红线面前,让模型“少看一点”

学术成果:《FastDriveVLA:Efficient End-to-End Driving via Plug-and-Play Reconstruction-based Token Pruning》(基于重建的新型视觉token剪枝框架)

第一作者:曹家俊,北京大学计算机学院多媒体信息处理全国重点实验室;合著机构:小鹏汽车

发表时间:2025年11月14日;AAAI 2026收录公布于2025年12月28日

(图片来源:Google Scholar)

VLA(视觉-语言-动作大模型),它有着惊人的驾驶智慧,但体积大得惊人。成千上万个视觉token随时都在像潮水一样涌入狭小的计算单元,巨大的计算开销增加了推理延迟,算力总有跟不上的时候,这就出现了两个问题:计算跑不动、关键信息丢失。在瞬息万变的时刻智驾出现致命“卡顿”,该怎么解决?

去年,在北京大学的实验室里,曹家俊(团队)和小鹏汽车开始审视那些被模型奉为圭臬的视觉信息——天空中的流云、路边早已路过的广告牌,这些token占据了大量算力资源,但对VLA输出的行为贡献不大。他们没有粗鲁地“砍掉”这些画面,而是像一位精细的外科医生,开发出了一套不改动原模型权重,但能将计算负载降低75%以上的token剪枝框架。

在研发FastDriveVLA的那段日子里,他们反复测试“删除”的边界,让模型去学习,哪些像素即使消失了,也不会影响对驾驶意图的判断,用MAE风格的像素重建技术,通过评估Token对前景区域重建的贡献度来判断其重要性,当最终实现7.5倍的计算量缩减、且在nuScenes测试中几乎不损失精度时,这份学术成果显示出了它最大的意义,填补了智驾领域缺乏精细前景标注的空白,赋予了VLA“排除杂念”的本能,让智能模型在迈向L4时变得更轻盈、更敏捷。

鲁洪良:为冰冷死板的机器注入“社会直觉”

学术成果:《Empowering safer socially sensitive autonomous vehicles using human-plausible cognitive encoding》(利用类人认知编码赋能更安全、具有社会敏感性的自动驾驶汽车)

第一作者:鲁洪良,香港科技大学(广州)博士;合著团队:东南大学、香港科技大学等团队

发表时间:2025年5月19日(PNAS《美国国家科学院院刊》)

(图片来源于网络)

好用的智能驾驶,应该是同时具备高效和安全的。眼下,各类智驾系统都太“有礼貌”了,而这种礼貌是源于对规则的死板遵守,而非对社会的真正理解。这种机器人的生硬,往往是引发路怒和交通事故的隐性诱因。

于是,鲁洪良与他的团队,决定做一个大胆的跨界:把人类的“认知编码”引入到代码。这听起来甚至有些哲学:如何量化“礼让”的权重?如何让车感知行人多变的运动轨迹?

他在论文中提出的“拟人化认知编码”,让车辆开始具备某种“社会直觉”。比如借鉴神经科学概念,通过编码给系统看得到的交通参与者做一次风险分级,同时赋予他们差异化权重,再将加权后的风险整合成“行为信念”,最终动态反映与潜在风险的时空关联性。这将使得智驾系统,会预判自身动作对周边交通流的影响(比如突然变道是否会引发后车急刹),从而实现更平顺的社会化交互。

当算法跑通的那一刻,不再是冷冰冰的概率分布,而是车辆在路口优雅地与其他交通参与者达成的默契。所以这份学术成果的意义,让我们看到了智驾落地的终点,不是冰冷的机器接管世界,而是机器能与人类共建交通规则。

明南:看清脚下路面的“褶皱”

学术成果:《TA-TOS: Terrain-Aware Tiny Obstacle Segmentation Based on MRF Road Modeling Using 3-D LiDAR Scans》(基于马尔可夫随机场的地形自适应小型障碍物分割算法)

第一作者:明南,上海交通大学自动化与感知学院2023级硕士;合著团队:上海交通大学智能网联电动汽车创新中心团队

发表时间:2025年6月10日(发表于IEEE Xplor)

(图片来源于:上海交大智能网联创新中心)

在上海交大智能网联汽车中心的实验室里,明南和团队不断在尝试破解一个难题:除了肉眼可见的人、车和被标注进白名单的常见异型障碍物之外,有没有一种不依赖GPU性能,专门解决坑洼碎石等小型障碍物的高精度检测方法呢?

在研发TA-TOS期间,明南正处于硕士求学的高强度阶段,这也是智驾技术火的发烫的技术大年,行业里都在追求“大模型”,但很少有人愿意俯下身子去研究路面的“褶皱”。

在这份学术成果里,他们像是一个手持放大镜的侦探,引入了马尔可夫随机场(MRF)来对路面建模,经过漫长的打磨和一次次修正,最终通过负指数能量函数实现了障碍物的鲁棒分割。这为智驾系统补上了一块“非平整路工况”的关键拼图。这份学术成果,也让外界注意到,真正的安全好用的智驾系统,不仅应具备强博弈能力,更应首先能看清脚下的路。

郑宇鹏:在无标注的荒原上,让机器学会自我进化

学术成果:《World4Drive: End-to-End Autonomous Driving via Intention-aware Physical Latent World Model》(融合多模态驾驶意图的物理潜世界模型端到端自动驾驶框架)

第一作者:郑宇鹏(图片资料暂时空缺),中国科学院自动化研究所2024级博士;合著机构:理想汽车

发表时间:2025年7月1日

能不能跳过人工标注,让汽车直接从原始传感器数据里,自己“悟”出来一条驾驶之道?

2025年7月前,正在攻读博士的郑宇鹏和正全力推进下一代智能驾驶技术的理想汽车,就一同在探索这个问题,到底能不能实现?

学术团队和理想团队一边打磨物理潜空间表征理论,一边拿着不断投喂的新模型做实战,最终他们发现,其实系统并不需要知道路上的物体叫什么,只需要知道在某种“驾驶意图”下,未来的物理空间会怎么去演化,这就是World4Drive的核心:一个“意图感知”的物理潜世界模型。它不再像传统的视觉模型那样,耗费巨大算力生成华丽的像素画面,而是在干涩但高效的“潜空间”里脑补出多条候选轨迹,然后再拿着预测结果和实际观测做一轮自监督比对,哪条路径最稳、哪条路径最不容易碰撞,最终完成“闭环自校准”。

实战下来的效果惊人,在完全没有人工标注的情况下,碰撞率降低了46.7%,轨迹偏差缩小了18.1%,训练收敛速度提升了整整3.75倍。

这意味着系统可以摆脱对昂贵标注数据的依赖,在缺失外部标注的极端环境下也能做出安全决策。这不仅为城区NOA的决策博弈提供了关键路径,也标志着智驾会从“看见世界”迈向“理解物理规律”完成进化。

陈小雪:0.4秒,让仿真训练进入“大批量自动化生成时代”

学术成果:《DGGT: Feedforward 4D Reconstruction of Dynamic Driving Scenes using Unposed Images》(自动驾驶仿真场景的无姿态图像4D前馈重建方案)

第一作者:陈小雪,清华大学智能产业研究院(AIR)赵昊课题组;合著结构:小米汽车

发表时间:2025年12月2日

(图片来源于:清华大学智能产业研究院)

智驾行业一直有个“昂贵的门槛”:想要把一段平凡的路测视频,复刻成可以在电脑里反复练习的4D仿真场景,传统方法(如3DGS或NeRF)通常需要针对每个视频进行长达数小时、甚至数天的计算优化。更糟糕的是,如果传感器的外参标定有一点点偏差,生成的画面就会像被打碎的镜子一样重影。对于追求“发布即量产、量产即好用”的智能驾驶系统来说,这种数据处理方式谈不上高效,更谈不上紧跟模型迭代的脚步。有没有破局之道?

已经在清华AIR实验室攻读博士的陈小雪,她想找到这个答案,也包括小米汽车。2025年,学术团队和小米汽车,日复一日的在挑战这个让行业头疼已久的效率瓶颈:能不能跳过漫长的训练,实现“瞬间复刻”?

学术团队在扎实的几何视觉理论基础上,大胆提出了“前馈重建”的新范式,企方则拿出了端到端路测原始数据,双方在实战中反复磨合,最终诞生的DGGT框架展现了令人震撼的性能:它将原本数小时的重建过程缩短到了惊人的0.4秒。

这意味着,智驾每天产生的数百万小时路测视频,几乎可以实时地转化为可交互的4D仿真教材!更具意义的是,参与论文研发的团队还攻克了“Unposed(无位姿)”难题,让系统能直接处理存在标定误差的原始数据。这份成果不仅为“闭环仿真”插上了翅膀,更标志着智驾仿真从“手工作坊式”的精雕细琢,正式跨入了“工业级流水线”的瞬间生成时代。

马楠:让智能驾驶“活过来”

学术成果:《Embodied Interactive Intelligence Towards Autonomous Driving》(迈向自动驾驶的核心技术框架)

第一作者:马楠,北京工业大学信息科学技术学院教授;合著团队:李德毅团队(中国工程院院士)

发表时间:2025年12月3日(发表于Engineering)

(图为马楠;图片来源于:北京工业大学新闻网)

当全行业都在通过卷参数、卷算力来提升感知精度时,马楠教授与李德毅院士注意到了一个被忽略的深层危机:自动驾驶车开得越来越像“准时却生硬的机器人”。在拥堵的路口,它们要么因为过于保守而永远动弹不了,要么因为无法预判行人的运动轨迹而频繁点头急刹。这种“缺乏人味”的表现,揭示了传统“感知→规划→控制”链条的局限。

(图为李德毅;图片来源于:网络)

2025年底,两位学者和他们的团队,在“驾驶脑”理论的基础上,正式提出了“具身交互智能”架构。这不再是针对某一个算法的缝缝补补,而是一场由学术界发起的范式革命:将自动驾驶从“看图做题”的计算机视觉任务,彻底转变为“具身智能体”与物理环境的博弈与协作。

论文中尖锐地指出了当下的三大难题:意图对齐难、泛化能力弱、被动响应多。为了解决这些痛点,团队提出了一个称为UniCVE的闭环智能架构,同时围绕“感知-认知-行为”三层模型展开,构建了一套让汽车具备“物理直觉”和“社会常识”的认知模型,让系统根据实时反馈的信息,不断优化内部预测与行为决策。这让最终的智驾行为,不再是单纯的避障,而是真正的像老司机一样,通过轻微的位移试探或意图表达,与周围的行人、车辆进行主动沟通。

虽然距离这种完全拟人化的驾驶全面落地尚需时日,但这份科研成果仍具有划时代的意义,这份构想已成为通往L5级无人驾驶的关键理论支柱,它为“后端到端”时代的进化指明了终极方向——让车辆从一台“按线行驶的机器”,变成有交互能力的“智能生命体”。

中科院自动化所:用世界模型解决“监督赤字”

学术成果:《DriveVLA-W0:World Models Amplify Data Scaling Law in Autonomous Driving》(基于世界模型增强自动驾驶数据规模化效应的研究)

第一作者:Liyingyan(音译李英艳,图片资料暂时空缺);合著结构:引望智能

发表时间:2025年12月18日

自动驾驶领域一直信奉着一条“暴力美学”定律——数据规模定律(Scaling Law):只要投喂的数据足够多,模型就会越聪明。然而,2025年的开发者们普遍撞上了一堵墙:监督赤字(Supervision Deficit)。

啥是“监督赤字”?在VLA模型里,输入的是高维且稠密的视觉信息流,但它的监督信号却往往是低维且稀疏的驾驶动作,模型的大部分表征能力都被白白浪费了,这就导致了模型无法充分学习复杂的行为。正当学术界和开发者们热议这一瓶颈时,一支来自国内顶尖学术机构和华为合作的研发团队,在去年12月悄然给出了破解的锦囊。

研究团队想到了一个办法,与其依赖稀疏的“动作”,倒不如让模型去学习稠密的“世界”,把预测未来图像作为一项稠密的自监督训练任务,也就是利用世界模型提供“稠密”的自监督信号,大量的实验最终证实了:在稀疏的动作监督下,VLA模型的性能会随着数据量的增加迅速饱和,所谓的Data Scaling Law效应在此大打折扣。

也可以理解成传统的VLA仅依赖稀疏的动作监督,而DriveVLA-W0是额外引入了稠密的视觉预测任务,迫使模型去理解环境,当模型被要求预测下一帧的完整视觉画面时,它就必须得学习和理解这个物理世界的真实运行规律,这为VLA模型提供了更丰富和稠密的学习信号,从根本上缓解了“监督赤字”,这套方案不仅提供了清晰的解题思路,也展示了世界模型在“生成”之外的另一条核心价值路径。

蒋安庆:在概率的丛林里,为智驾找寻“最优解”

学术成果:《DiffVLA:Vision-Language Guided Diffusion Planning for Autonomous Driving》(视觉-语言引导扩散规划赋能自动驾驶)

第一作者:蒋安庆(图片资料暂时空缺),清华大学智能产业研究院(AIR) ;合著结构:博世中国研究院

发表时间:2025年6月3日;CVPR2025正式收录于同年6月17日

当你开车进入一个极其拥堵的路口,左侧有加塞的公交车,右侧有乱穿马路的电动车,作为人类司机,你的大脑其实瞬间模拟了无数种可能:是稍微减速避让?还是果断切斜前方通过?这种“多路径生成与优中选优”的能力,正是VLA最稀缺的。

2025年初,蒋安庆与研发团队注意到了传统端到端模型的一个通病:由于采用单一的动作预测,模型在复杂博弈中往往显得“优柔寡断”,或者只能给出一个平庸的平均方案。

为了破解这一局限,蒋安庆(团队)将大语言模型(LLM)的常识推理能力与扩散模型(Diffusion Model)的生成能力巧妙结合,提出了DiffVLA框架,并经过博世中国研究院进行了大量验证,来确保这套复杂的数学推演能够真正适配真实的行车逻辑。

DiffVLA的核心创新在于,它不再让模型只猜一个“标准答案”。模型会首先通过视觉和语言指令理解当前的复杂语义(如路况拥堵,请寻找超车空隙),随后利用扩散模型在空间中像“泼墨”一样生成大量可能的候选轨迹。

最关键的一步是,系统会根据语言指令的引导,从这些候选方案中筛选出最符合安全、效率与舒适度的路径。它赋予了自动驾驶系统一种前所未有的“决策弹性”,也为自动驾驶的闭环性能树立了新的标杆。

林宏彬:让端到端学会“思考”

学术成果:《FutureX: Enhance End-to-End Autonomous Driving via Latent Chain-of-Thought World Model》(基于潜在思维链推理的自动驾驶轨迹优化框架)

第一作者:林宏彬,香港中文大学(深圳)博士;合著结构:小鹏汽车

发表时间:2025年12月12日

(图片来源于:网络,侵删)

现在的端到端模型反应虽然很快,但在处理复杂路口博弈时,往往显得有些“一根筋”。它们更像是一个只有肌肉记忆、不懂战术的短跑运动员,看到障碍物会躲避,却不理解“躲避”背后的连锁反应。人类司机的强大就在于会预判,比如看到路边有皮球,脑子里会立刻跳出“后面可能会跟着小孩”,这个就叫逻辑链。那么,能不能给自动驾驶也装上这种“先思考、再动手”的大脑?

2025年末,林宏彬和他的团队,与小鹏汽车一起试图去破解智驾大模型“逻辑缺失”的顽疾。他们面临的挑战极其硬核:大语言模型的思维链(CoT)虽然聪明,但极度消耗算力,如果车在路口思考太久,就会产生致命的延迟。

他们想到了一个办法,不在冗余的像素世界里思考,而是在极度压缩的“潜空间(Latent Space)”里,点亮思维链。这套名为FutureX的框架,为系统设计了一个“自动思考开关”,在路况简单的环路上,模型保持高效的瞬时反应;一旦进入人车混行的复杂工况,开关开启,模型便会在潜空间里进行多步未来演化的“逻辑预演”。

实战数据显示了这套“三思而后行”方案的威力。在NavSim等闭环模拟中,FutureX显著降低了碰撞率,展现了极强的博弈能力。这份成果最大的意义在于,它证明了端到端系统不应只是机械地模仿动作,而应具备逻辑推演的能力,这让智驾大脑告别了盲目执行,揭开了属于智驾系统的“认知”大幕

特别推荐:这篇论文10年了,含金量还在上升

尽管本文人选的入围范围,是2025年内在顶会/顶刊发表过高引论文的开发者,但有一个例外人选不得不提:任少卿,现任蔚来副总裁、自动驾驶研发首席专家,中国科技大学讲座教授。

他在2015年作为第一作者发表的《Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks》(基于区域建议网络的实时目标检测),这篇让深度学习真正具备“上车资格”的开山之作,经过10年时间,成为智能驾驶领域引用数最高的(11.5万次)经典论文。直到今天,它依然是无数感知算法的根基,在NeurIPS 2025(人工智能顶会)获得了时间检验奖。

回到2015年,那是一个感知算法极慢、完全无法用于动态驾驶的年代。人们面对的是一个几乎无解的矛盾:想要识别得准,计算量就大得没法跑;想要跑得快,准确率就惨不忍睹。任少卿用一种近乎优雅的物理直觉,提出了“候选区域网络(RPN)”。

这个设计的精妙之处在于,它让神经网络学会了“先看一眼哪里像物体”,并实现了特征的完美共享,直接把物体检测的速度提到了“准实时”的门槛。

10年后的今天,《Faster R-CNN》所开创的锚点框和区域建议思想,影响力还在增长。超过11.5万次的引用记录,证明了它作为感知论文“北斗星”般的地位。

写在最后:群星闪耀的时刻,再一次开始了

在跨越拐点的过程中,必然有分歧和争论,有时声音还蛮大,但都是插曲,因为争论过后不久,方向和步调很快就变得一致起来。

因为在中国智驾的前面,有且仅有一座高山,大家离他越来越近,近的几乎已经可以听到他的心跳了。这种新鲜感让人兴奋不已。

但越过这座山之后,前方就是茫茫黑夜,再无高举火把的手。在历史的刻度上,我们即将到达人类认知的新边疆。巨大的孤独即将袭来。怎么办?

不知道。

但我们知道,孤独和无助,并不是人类前进的障碍,傲慢和无知才是。正因为孤独和无助,才让人类得以更好的连接。而美好的连接,会激发出探索未知的勇气。本文推荐的11篇重磅论文的第一作者,及合著团队(机构),正是勇敢探索未知的范例。

看到他们,那些年轻人的脸,相信你会有一种鸡皮疙瘩炸起的感觉:群星闪耀的时刻,再一次开始了。

任少卿在十年前种下的那颗感知的种子,已升起为一颗大星。陈小雪用0.4秒的奇迹,让机器学会了如何在瞬息间复刻出“平行世界”;杨磊为那些轻飘飘的视觉幻觉钉上了物理的骨骼。他们解决的是“真实感”的问题,让智驾的进化拥有了无穷无尽、且绝对可信的数字战场。

当数据量堆叠到令人窒息的千万小时时,李英艳敏锐地捕捉到了“监督赤字”的阴影,她用世界模型作为杠杆,撬动了数据进化的第二曲线。这种对效率的极致追求,与曹家俊那把剪向冗余Token的“手术刀”交相辉映——他们一个在为大脑扩容,一个在为神经减负。

更令人欣慰的变化,发生在机器的“性格”里。郑宇鹏试图在潜空间里寻找机器的自我意识,让“自监督”取代了昂贵的人工标注;而林宏彬和蒋安庆则分别用“思维链”和“扩散规划”,教会了模型在复杂的人性博弈中学会三思而后行。从此,车不再是冰冷的铁盒,它开始具备了某种程度上的“博弈直觉”与“决策弹性”。

最后,马楠教授与李德毅院士提出的具身智能范式,像一颗最新的星,照亮了更远的方向:智驾不应只是看图做题的算法,它应该是具备社会常识、能与人类共情的生命体。

这些勇敢的充满创造力的探索,展现了当代中国智驾开发者们的格局和气象。在1月31日举行的【2025智驾天梯榜年度盛典】上,我们将邀请他们中的一部分,作为“2025智驾开发者50人”的代表进行现场分享,敬请关注。

来源:第一电动网

作者:张卫东

本文地址:https://www.d1ev.com/carnews/yongche/284837

文中图片源自互联网,如有侵权请联系admin#d1ev.com(#替换成@)删除。