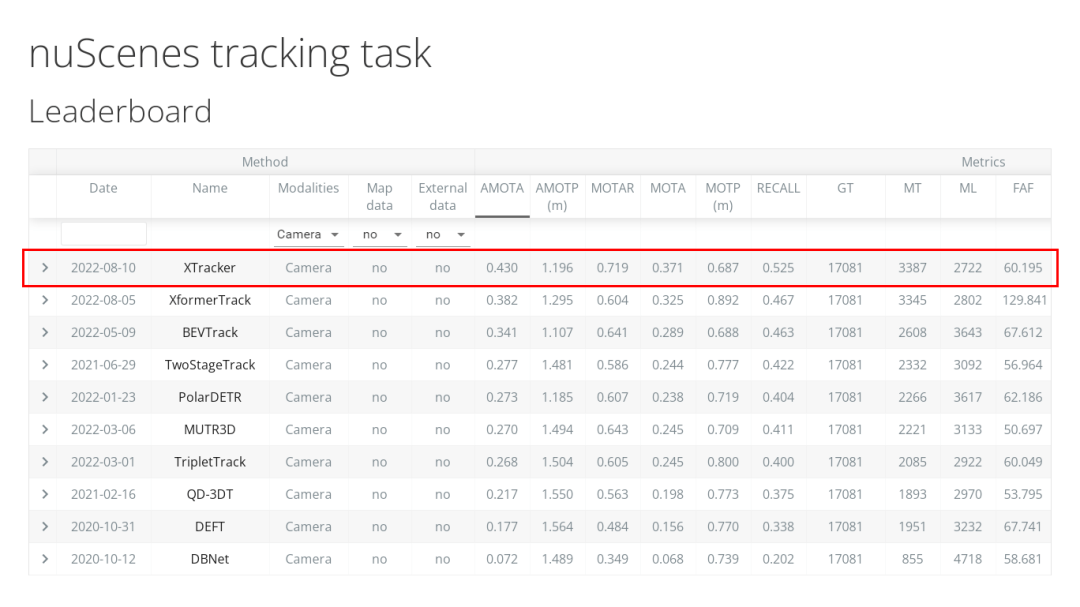

近日,广汽研究院X lab团队在国际权威的nuScenes自动驾驶测试竞赛中,依靠自主研发的XTracker方法在动态多目标跟踪MOT(Multi-Object Tracking)领域获得纯视觉榜单全球第一名,并将关键指标AMOTA(多目标跟踪平均准确度)从此前39.8%大幅提升到43.0%。

nuScenes数据集是国际公认的权威自动驾驶公开数据集之一,数据采集自美国波士顿和新加坡的实际自动驾驶场景,是第一个提供360度的全传感器覆盖,同时包括摄像头、激光雷达和毫米波雷达数据的数据集,是唯一提供雷达数据标注的数据集,覆盖多种气候条件及多种道路场景,数据集总共包含了1000个场景、140万帧图像、39万帧激光雷达点云、23个物体类别、140万个三维标注框。

动态多目标跟踪MOT是对感知数据中检测出的多个动态目标重建运动轨迹,以确保随着时间推移动态目标轨迹ID不变,是自动驾驶中目标意图与轨迹预测、决策规划等下游任务的重要依赖项,在自动驾驶行车中跟车、变道等场景中起到关键作用。

近年来,随着自动驾驶的火热,数据、算法、算力成为企业之间的竞争要塞,一方面参与纯视觉3D目标跟踪的团队技术实力均处于世界先进水平,竞争十分激烈,不仅涵盖了理想汽车、地平线、DeepMotion、Aurora等业界知名企业,还吸引了麻省理工学院、卡内基·梅隆大学、清华大学、复旦大学、华中科技大学等国内外重点高校;另一方面,纯视觉多目标跟踪需要处理不同光线、视线遮挡、图像模糊等关键问题。目前业内尚未有成熟的技术可参照,识别跟踪速度慢、目标运动模糊、准确率低等问题成为行业共同难点。

广汽研究院X lab团队提出了XTracker方法,整体上有三大技术突破:

一是在自动驾驶行业内首次将跟踪的多视角数据,通过Transformer统一转换到BEV(Bird's Eye View, 鸟瞰图)特征空间下,从Decoder输出聚合后的BEV表征。

二是首个在BEV空间下的端到端跟踪方法——XTracker,解决了传统的跟踪方案主要采用运动建模或相似性建模,导致检测和跟踪之间存在信息流断点,XTracker采用端到端的统一建模方式,使检测和跟踪能够一起训练,结构简单、高效。

三是结合自车运动和多帧连续变化的方法,更好地完成时序特征的对齐,提高BEV表征空间下运动预测的鲁棒性*。

目前自动驾驶主要分为两条探索路径,一条是以摄像头为主的视觉感知路线,另一条是以激光雷达为主的多传感器融合路线。在自动驾驶视觉感知技术大规模应用过程中,尤其是在汽车对周围运动物体的感知跟踪领域,动态多目标跟踪MOT是技术要求极高的基础性感知技术任务,该技术作为自动驾驶感知部分的必备环节,将直接影响到自动驾驶系统鲁棒性和用户体验感。广汽研究院X lab团队深耕自动驾驶视觉领域,推进多目标跟踪技术在自动驾驶落地场景中的应用,助力广汽智能化升级。

来源:第一电动网

作者:王鸣幽

本文地址:https://www.d1ev.com/news/qiye/182997

文中图片源自互联网,如有侵权请联系admin#d1ev.com(#替换成@)删除。