HiEV消息(文:爱LiDAR的小飞哥)

如何简单地判断一款补盲激光雷达的成像效果?

业界通常有几个指标:视场角大小、测距范围,以及角分辨率。

一款优秀的补盲激光雷达,通俗来说:既要看得广,还要看得清。

上期我们讨论了补盲激光雷达如何看得够广的话题,这期我们聊聊补盲激光雷达的另一个关键问题——如何“看得够清”,即角分辨率该如何定义。

补盲雷达角分辨率:久经思量的Trade-off

什么是激光雷达角分辨率

如果把激光雷达类比成人眼,那视场大小相当于人眼视野的宽窄,分辨率是决定人眼对图像细节辨识能力最重要的因素之一。

分辨率在激光雷达领域对应为角分辨率,指的是相邻两个激光扫描点之间的角度间隔,一般以度(°)为单位。由于目前激光雷达有很多种扫描方式,每种方式在扫描点分布上的差异,导致扫描点并不绝对均匀,因此这里讲的激光雷达角分辨率是一个等效平均的概念。

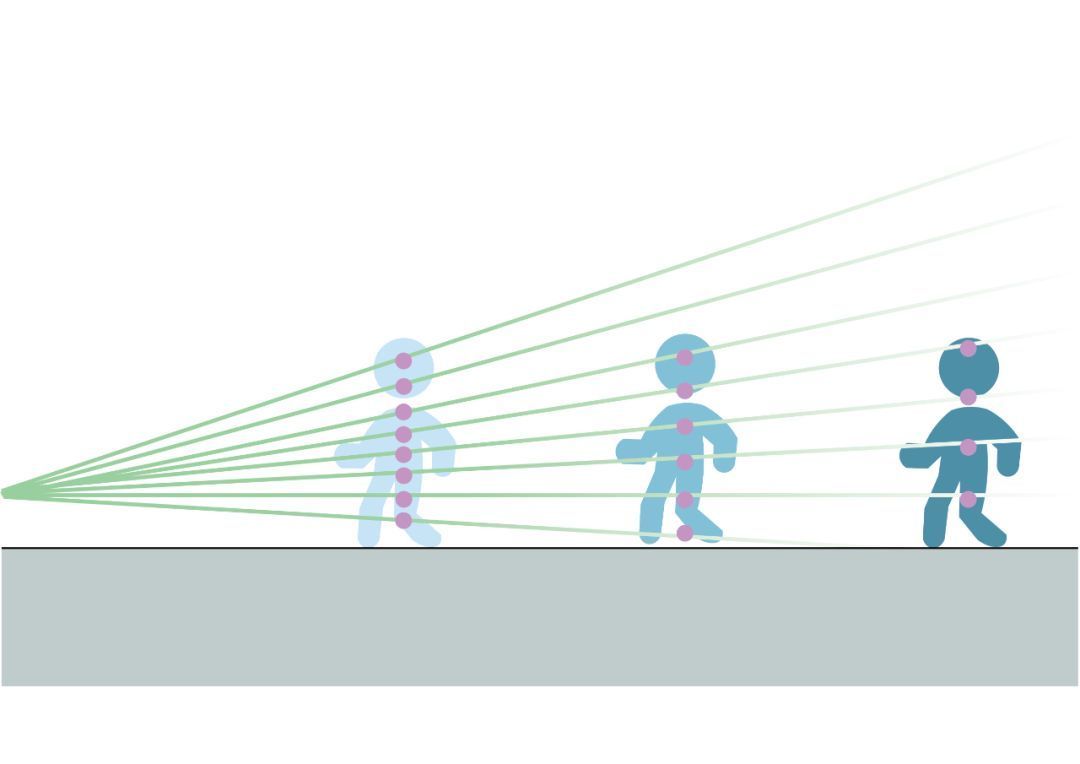

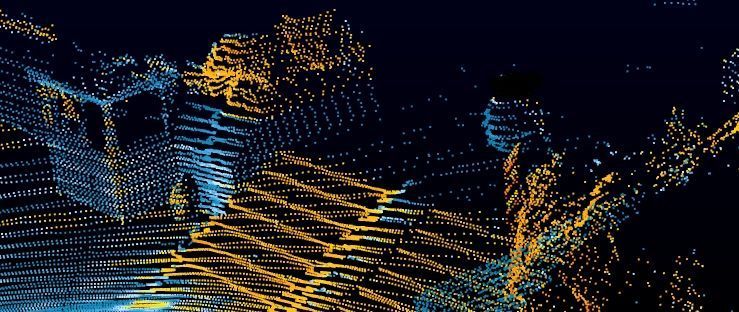

直观理解,角分辨率越小,单位空间角内分布的激光点数就越多,其对于物体的分辨能力就会越强。相同角分辨率下,对同一物体,距离越远探测到的激光点数越少,如图所示。

补盲激光雷达,角分辨率不能太小

激光雷达的角分辨率定义是非常讲究的。

相比于长距前向激光雷达,短距补盲激光雷达的分辨率定义更加复杂,考量因素更多。

首先,要确定补盲激光雷达所需覆盖的感知范围。

现阶段,补盲激光雷达的探测距离范围一般在25~30米(@10% 郎伯反射,指入射能量在所有方向均匀反射)。

当需求感知距离达到20m(※)时,如果要对典型目标物输出高置信度的感知结果,粗略估计其平均角分辨率需要达到0.5°。

※ 如上表所示,对典型的目标物(小轿车、行人和骑行人)来说,即使考虑到MEMS扫描的特殊性,在20米距离下也能有足够多点数来支撑算法准确输出高置信度的目标级感知结果。

其次,补盲雷达的应用场景不仅要求它对近距离的物体有探测输出,同时对被测物体轮廓的细节也有一定要求。

举个例子,在自动泊车场景中,补盲雷达需要对非结构化的各类异形物体进行探测,作为对现行摄像头与超声波雷达识别能力不足的补充,实现安全快捷的泊车。

那么,是否可以简单粗暴地认为角分辨率越小越好?直接将角分辨率定为0.1°甚至更小能实现完美效果吗?

答案是否定的。

角分辨率并不是越小越好,过小的分辨率会对激光雷达的应用造成负面影响。

当我们用手机上号称1亿像素的主摄像头拍照时,极大概率输出照片的分辨率只有几百万,至多千万像素。原因在于1亿像素虽然提升照片的细节,但却也牺牲了像素的尺寸,导致图像的感光性能并不出色。

此外,过多的像素会导致存储空间的占用。实际上,绝大部分情况下,千万像素已经能够提供非常出色的感官效果,毕竟需要把图片放大数倍看细微细节的应用少之又少。

同样的考量对激光雷达也适用,特别是对补盲激光雷达,角分辨率不能太小。

补盲激光雷达的视场角都非常大,尤其垂直视场角通常是长距激光雷达的3倍。如果这时将角分辨率设定得非常小,就会造成补盲激光雷达单帧的数据量过大,对域控的算力造成压力。

激光雷达单帧数据量对比

同时,在一辆自动驾驶车上,其所需的补盲激光雷达数量通常比长距雷达多,单帧数据量过大将对域控的算力造成更大的压力。

也许有人会说,激光雷达的数据量与目前车载摄像头的数据量比是小巫见大巫,对越来越大的算力平台而言不算什么。

确实,对于嵌入式神经网络处理器(NPU)的算力总量而言,激光雷达占用的算力不大。但对于目前主流的算力芯片而言,中央处理器(CPU)才是拖油瓶;激光雷达的数据在进入网络前需要调用CPU来进行必要的数据解析、滤噪等操作,更不用说并发的超大激光雷达数据量对于车载以太网络造成的压力。

平衡点在哪里?

一方面,角分辨不够小,无法满足对物体细节的探测要求;另一方面,角分辨率过小,会对域控算力造成压力。平衡点在哪里?

实际上,在短距激光雷达的感知距离内,稍高的角分辨率就能保证足够的物体细节感知能力,不需要对角分辨率过度苛求。

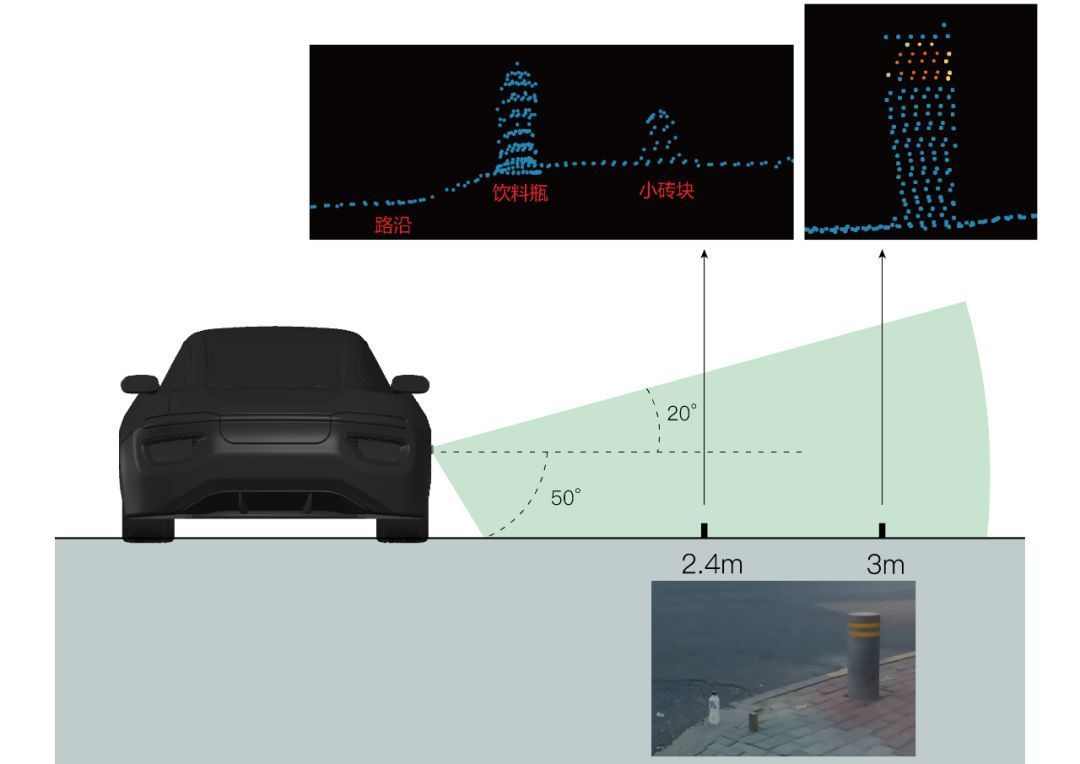

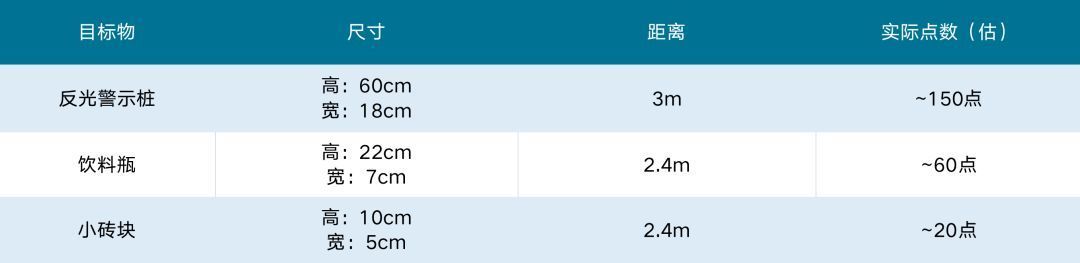

以一径的第一款短距激光雷达ML-30s为例,这款产品的平均角分辨率为0.44°×0.44°。过去三年中,众多典型场景的实际落地,已经充分证明这样的角分辨率组合能够在近车身区域取得极佳的成像细节。

上图是ML-30s在典型场景的测试结果,可以清晰地分辨出饮料瓶、小砖块和远处的路桩。更重要的是,从点云图中还能清晰地分辨出路沿的坡度变化。

ML-30s实际探测能力总结

此外,为了达到上述的小物体分辨能力,除了足够的角分辨率外,测距的精准度也是关键。测距精度不高,将无法形成较为清晰的点云轮廓,也无法对上述细微坡度进行精准探测。

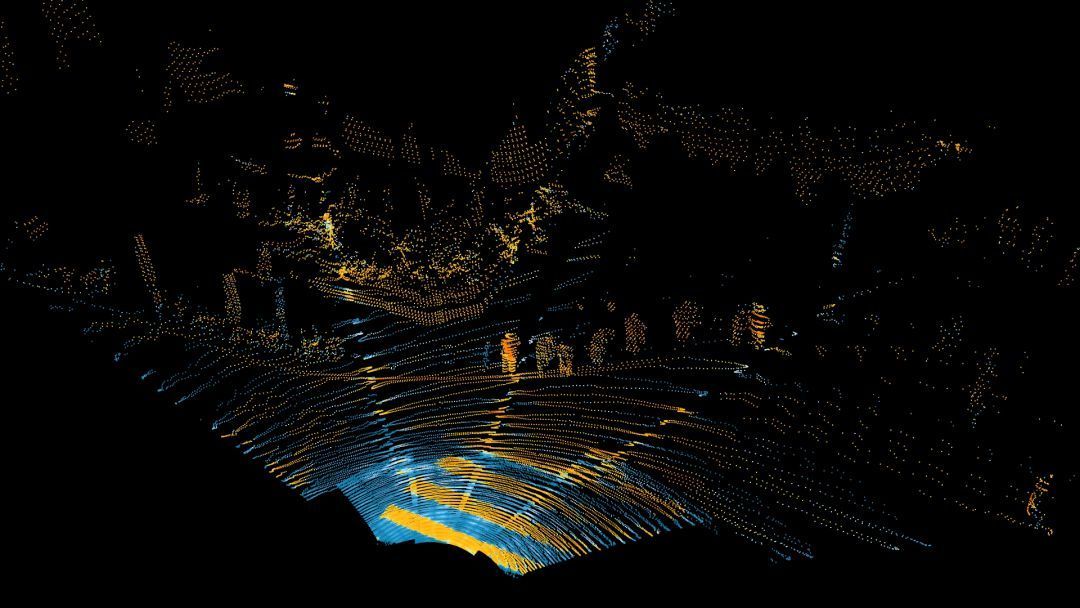

更多的探测场景如下图所示:

以上可以看出,恰当的角分辨率,让补盲激光雷达能够探测到足够致密的点云,大大增强近车身区域的感知能力,从而为实现各类近车身的高难、高复杂度的场景提供可能。

然而,合适的角分辨率仅能够保证看清局部,要看清全局,全视场一致性是不能被忽视的性能。

全视场一致性:无差异的感知能力

补盲激光雷达在追求大视场角和高分辨率的同时,往往容易忽略一个很重要的维度:无差异的大视场感知能力。

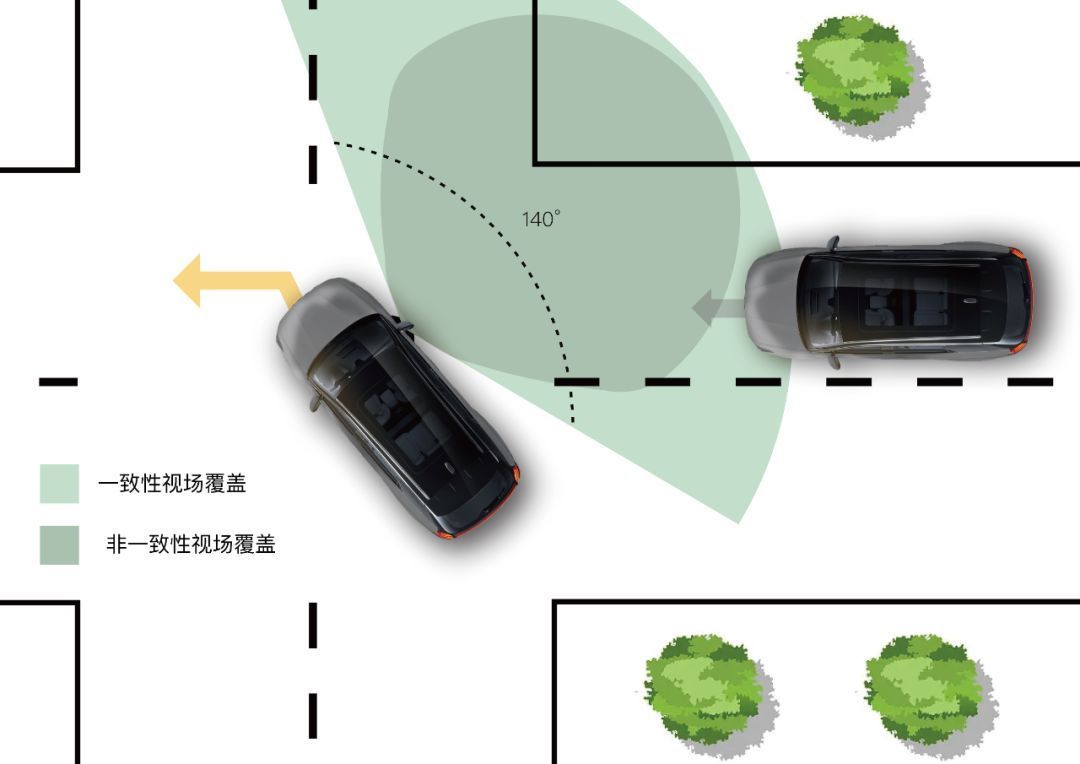

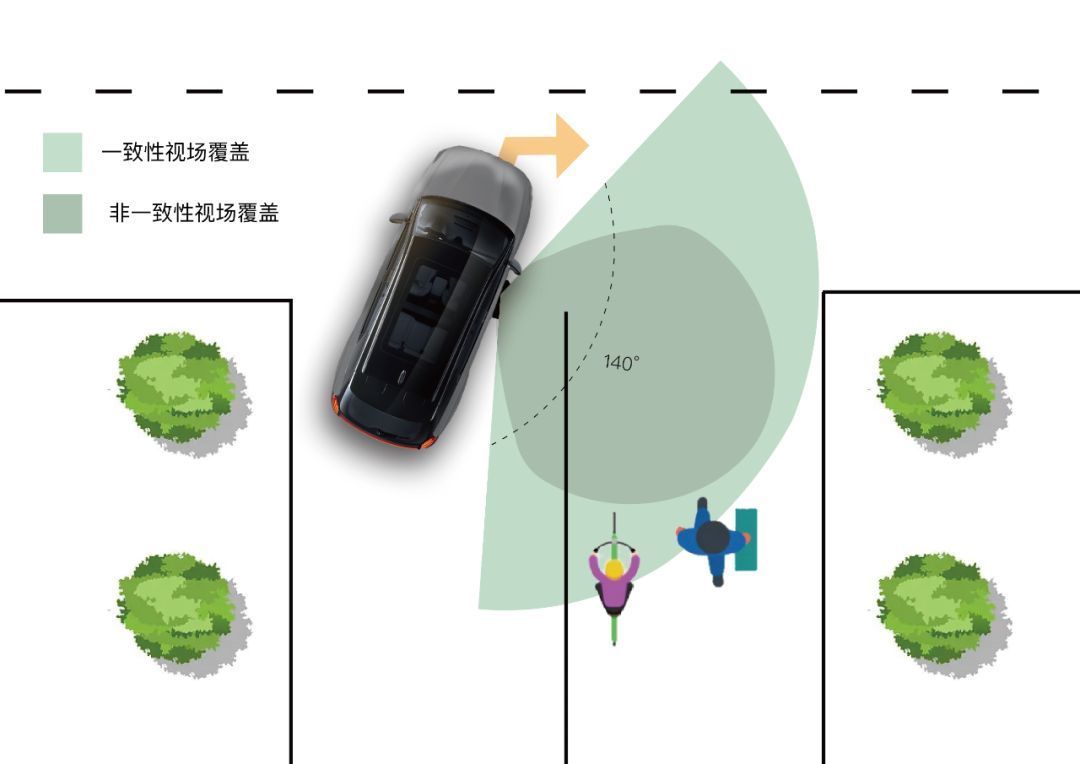

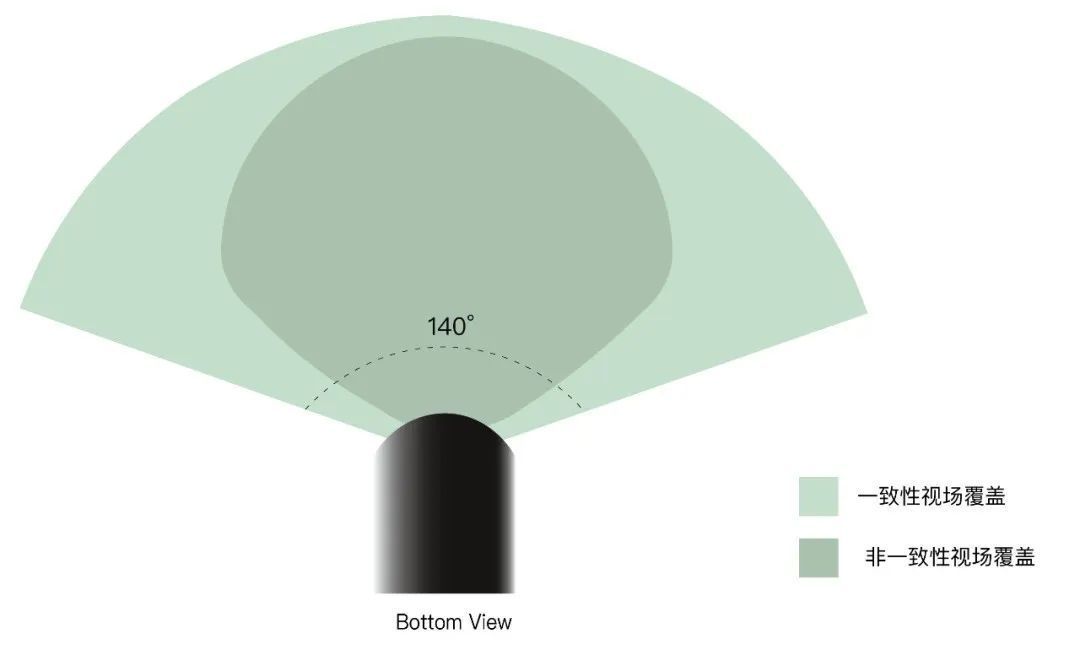

实现无差异感知的关键是视场内测距能力的一致性,特别是水平视场测距的一致性。

由于很难在产品规格参数上有所体现,测距一致性极容易被忽略。然而对主打车辆近场探测的补盲雷达而言,其主要任务就是在视场角所覆盖的范围内对环境有可靠的、无差别的感知。

因为从应用场景上看,无法严格区分哪个方向要看得远、哪些地方要看得近。甚至,越是边沿视场区域,对补盲雷达的探测能力的要求就越高。

我们来看2个典型场景。

在车辆左转场景中,相比于区分主次的视场定义方式,全视场测距能力一致更能确保掉头的全过程全视场无差别地感知对向来车,从而更好地选择安全舒适的驾驶策略;相应地,如果个别视场的测距明显较短,将造成目标跟踪时断时续或目标物突然出现,而这都是智驾系统不愿意看到的结果。

在车辆右转场景中,弱势交通参与者的速度相对较低,但由于潜在碰撞场景对人的伤害威胁更大,这样的场景对探测要求反而更苛刻。这种情况下,视野范围内无差别探测能力能保证激光雷达持续稳定地感知到骑行者和行人,最大程度保证盲区的安全性。

全视场测距一致的必要性已经明确,但实际的应用中却存在一定挑战。这是因为:

与一般大角度覆盖传感器一样,激光雷达的边沿视场也存在能力下降的情况,越靠近边沿,激光雷达的视场探测能力会逐渐下降。

因此,如何从工程实现角度尽可能避免边沿视场测距能力下降以实现无差别感知,就显得至关重要。特别是对类似相机架构的Flash激光雷达而言,其工程实现上会面临更大的挑战。

基于对角分辨率和视场测距一致性的深入思考和研究,以及实际应用中多领域的客户反馈及持续迭代经验,我们认为一款优秀的专为自动驾驶而生的补盲激光雷达产品应当是这样的:

· 具有~0.5°“恰当”的角分辨率;

· 兼顾适中的数据量、广阔的视场角,看得够广、够清晰;

· 能够实现最大程度持续、无差别的有效感知。

而要成为一款性能优异的激光雷达,真正实现安全、舒适的自动驾驶出行体验,要考量的因素远远不止于此,还需要在产品的内在逻辑上进行严密的设计,做到不仅能用,更要好用。

下一篇,我们将详细聊聊,补盲激光雷达如何做到「好用」,也就是产品的软件功能如何更好地服务前装量产。

来源:第一电动网

作者:HiEV

本文地址:https://www.d1ev.com/kol/191253

文中图片源自互联网,如有侵权请联系admin#d1ev.com(#替换成@)删除。